什么是GPU容器共享技术cGPU

999+|...条评论

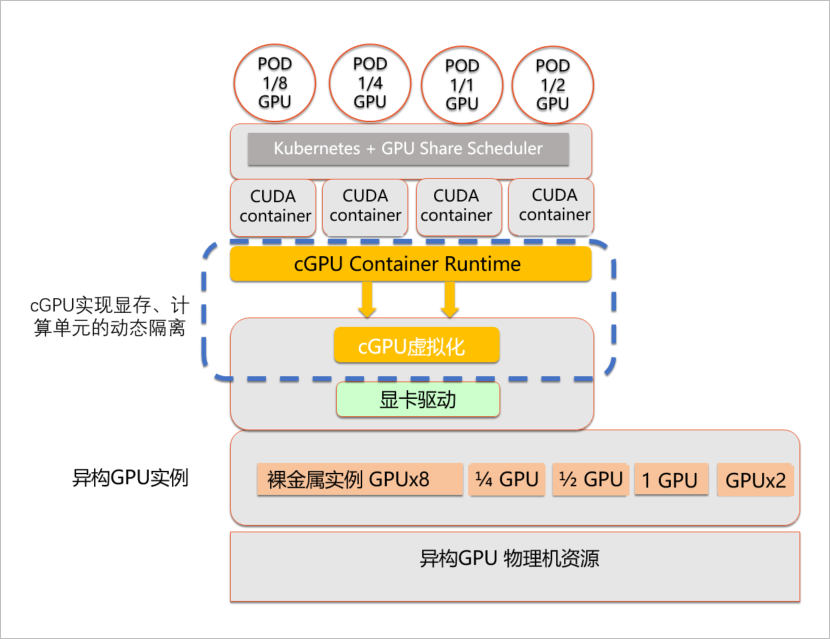

什么是GPU容器共享技术cGPU?GPU容器共享技术cGPU是阿里云首创的基于内核虚拟GPU隔离的容器共享技术。即多个容器共享一张GPU卡,从而实现业务的安全隔离,提高GPU硬件资源的利用率并降低使用成本。

为什么选择cGPU?

更加开放

适配开源标准的Kubernetes和NVIDIA Docker方案。

更加简单

无需重编译AI应用,运行时无需替换CUDA库,升级CUDA、cuDNN的版本后无需重新配置。

更加稳定

相较于CUDA层API以及一些cuDNN非开放的API的多变和不稳定性,针对NVIDIA设备的底层操作更加稳定和收敛。

完整隔离

支持GPU的显存和算力隔离。

无实例限制

能够适用于GPU裸金属实例,虚拟化实例,vGPU实例等各种GPU实例。

cGPU架构图

为了提高GPU硬件资源的利用率,需要在单张显卡上运行多个容器,并在多个容器间隔离GPU应用。

cGPU通过自研的内核驱动为容器提供虚拟的GPU设备,在保证性能的前提下隔离显存和算力,为充分利用GPU硬件资源进行训练和推理提供有效保障。您可以通过命令方便地配置容器内的虚拟GPU设备。

以上就是关于“GPU容器共享技术cGPU”的相关介绍,如果亲们还有什么不清楚的问题,可以直接咨询我们的在线技术客服!筋斗云期待与您合作!